-

Pętla OODA – wpływ entropii i mechaniki kwantowej na procesy podejmowania decyzji

Pętla OODA „Observe-Orient-Decide-Act” (Obserwacja-Orientacja-Decyzja-Akcja) jest cyklicznym adaptacyjnym modelem obserwacji, szybkiej oceny sytuacji, podjęcia decyzji i działania. Pętla została stworzona przez pułkownika lotnictwa wojskowego USA Johna R. Boyda na przełomie lat 70-tych i 80-tych XX wieku na potrzeby prowadzenia walki powietrznej. Pułkownik John Richard Boyd jest uznawany za jednego z najwybitniejszych strategów i filozofów sztuki wojennej w nowożytnej historii, a także konstruktora nowoczesnych samolotów. Pod jego nadzorem stworzono myśliwce F-15 i F-16. O wyjątkowości Johna Boyda świadczy jego interdyscyplinarność. Warto przeczytać jego biografię i filozofię służby: nie dla odznaczeń lecz dla kraju. Inspiracją dla Boyda było nie tylko jego doświadczenie i obserwacje na polu walki, ale także m.in. zjawisko entropii i…

-

Kiedy zniknie błoto i ruszą czołgi?

Czasami fizyka jest jak szwajcarski scyzoryk. Dostarcza narzędzia, które pomagają sprostać wyzwaniom czasu wojny i czasu pokoju. Tym razem wojna przyczyniła się do rozwoju rolnictwa i nawadniania. Poszukiwania rozwiązania problemów z błotem na polach II Wojny Światowej przyczyniły się do postępów prac w nawadnianiu upraw, zwiększeniu plonów i optymalizacji zużycia wody w rolnictwie. Czołgi w błocie Problemy z pokonywaniem miękkiego gruntu przez czołgi stały się widoczne już podczas I Wojny Światowej. Gdy w trakcie II Wojny Światowej teatr działań na froncie zachodnim znów przeniósł się do północno-zachodniej Europy wiedziano, że problem błotnistych nieprzejezdnych dróg i pól znów powróci. Niemcy boleśnie odczuli to na własnej skórze w czasie inwazji na Związek…

-

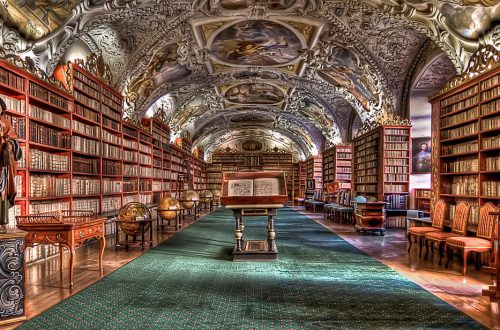

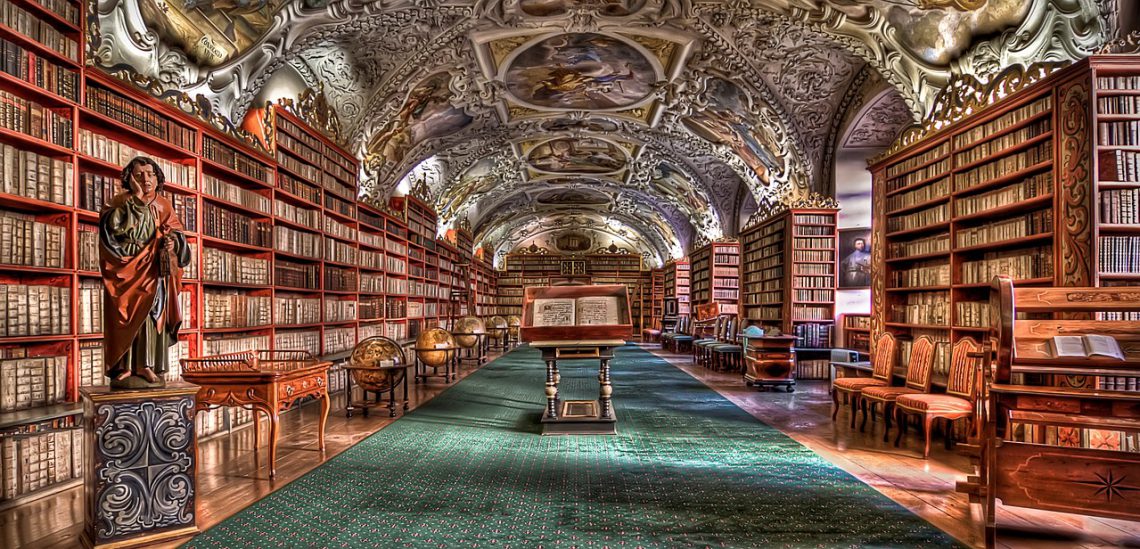

Perkolacja, czyli rozwiązywanie problemów przy kawie.

Parzenie i picie kawy to czynność, która niezależnie od pory dnia pobudza wiele innych osób do dalszej aktywności, wpływając na nasz nastrój i energię. Natomiast sam fizyczny proces parzenia kawy może być zastosowany do rozwiązania problemów w wielu dziedzinach naukowych, funkcjonowania przedsiębiorstw i codziennego życia nas wszystkich. Jeśli planujesz spotkanie to przy kawie Od najmłodszych lat aromat kawy jest dla mnie symbolem kreatywności i pozytywnej werwy w rozwiązywaniu problemów. Pamiętam jak rodzice zawsze razem pili kawę i rozmawiali o różnych rzeczach. Z obserwacji wiem, że kawa podawana na spotkaniach, czy podczas pracy w grupach jest jak krew roznosząca tlen. Potwierdza to eksperyment przeprowadzony na Uniwersytecie w Kalifornii w 2018 roku…

-

Rozwiązywanie równań różniczkowych cząstkowych za pomocą głębokiego uczenia

Równania różniczkowe cząstkowe są jednym z podstawowych narzędzi matematycznych do opisu rzeczywistego układu i zachodzących w nim zmian w czasie. Stosuje się je począwszy od fizyki, gdzie wzięły swój początek, przez chemię, biologię, aż po socjologię i ekonomię. Niestety dla większości opisywanych zjawisk tworzą one skomplikowane układy równań. Ich rozwiązanie analityczne jest możliwe tylko w bardzo niewielu przypadkach. Ogromną większość można rozwiązać tylko numerycznie na bardzo silnych komputerach, a i tak zajmuje to bardzo dużo czasu: dni, tygodnie, a nawet miesiące. Próby wykorzystania sieci neuronowych i głębokiego uczenia bezpośrednio do modelowania natury na podstawie danych natrafiły na bardzo poważne problemy, o czym możecie przeczytać w osobnym artykule – Fizyka zmienia…

-

Fizyka zmienia uczenie maszynowe

Uczenie maszynowe (ang. machine learning – ML) odcisnęło piętno praktycznie na każdym aspekcie naszego życia i to w bardzo krótkim czasie. Ten element sztucznej inteligencji zrewolucjonizował nie tylko handel i e-commerce odcisnęło piętno zastosowanie elementów sztucznej inteligencji uczenie maszynowe w większym lub mniejszym stopniu Nie ma chyba już aspektów życia w którym uczenie maszynowe nie odcisnęłoby swojego piętna. Modele naukowe a życie Każdy model fizyczny ma za zadanie jak najbardziej wiernie opisać rzeczywistą sytuację lub proces. Dotyczy to zresztą wszystkich modeli naukowych od fizyki przez chemię i biologię po ekonomię i socjologię. Modele bazując na odkrytych prawach naturalnych i teoriach biorą pod uwagę wiele zmiennych, które opisują realne sytuacje i…

-

Entropia – pomost pomiędzy fizyką a uczeniem maszynowym

Entropia jako koncept naukowy i mierzalna wielkość określająca nieuporządkowanie, niejednorodność, przypadkowość i niepewność funkcjonuje we wszystkich naukach przyrodniczych, socjologii, ekonomii i teorii informacji. Krótko mówiąc im większa entropia tym większy nieporządek, a mówiąc potocznie chaos i bałagan. Pierwszy raz entropia została zdefiniowana w połowie XIX wieku przez fizyków w termodynamice jako funkcja stanu określająca kierunek zachodzących zmian i przepływu energii. Bardzo szybko zaczęto koncepcję entropii termodynamicznej przekładać na inne dziedziny naukowe. Szybko też naukowcy doszli do wniosku, że musi być ona powiązana z tak abstrakcyjnym tworem jak informacja. Z punktu widzenia uczenia maszynowego to właśnie analogia pomiędzy entropią w fizyce a entropią w teorii informacji umożliwia lepsze wykorzystanie uczenia maszynowego…

-

Narzędzia do automatyzacji eksploracyjnej analizy danych (EDA) w Python

Zrozumienie danych jest pierwszym i najważniejszym krokiem w Data Science i budowie dobrego modelu uczenia maszynowego. Służy do tego analiza eksploracyjna danych (EDA, ang. Exploratory Data Analysis), która jest iteracyjnym, ekscytującym, ale często bardzo żmudnym procesem. Proces zrozumienia i przygotowania danych, którego EDA jest nieodłączną częścią stanowi nawet 80% całego czasu poświęconego na budowę modelu. Z pomocą przychodzi automatyzacja eksploracji, która jest kluczem do usystematyzowania tego procesu i redukcji kosztów. Biblioteki w Python przeznaczone do manipulacji danymi, wizualizacji i uczenia maszynowego jak pandas, scikit-learn, czy seaborn, zawierają w sobie narzędzia, które analizę ułatwiają, jednak nie są stworzone z myślą o automatyzacji powtarzalnych czynności. Ta jest zostawiana twórcom eksperymentów i programistom.…

-

Środowisko pracy Data Science w Python

Każdy specjalista ma swój własny ulubiony zestaw narzędzi i warsztat pracy. Przy okazji uruchomienia kolejnej wersji środowiska wirtualnego Python dla Data Science postanowiłem podzielić się z Wami swoim podstawowym zestawem narzędzi. Conda jako środowisko pracy Ze względu na system operacyjny MS Windows najwygodniejszym środowiskiem jest dla mnie Conda. Przede wszystkim dlatego, że mam do dyspozycji gotowe, stabilne, przetestowane paczki działające pod Windows’em i nie muszę tracić czasu na ich kompilacje (co nie zawsze jest bezproblemowe), czy też ściągać pliki wheel lub egg. Oczywiście nie wszystko znajduje się w repozytoriach Conda, ale do dyspozycji mamy ciągle PyPI. Dodatkowe kanały z paczkami, które należy dodać do standardowej instalacji Conda: Stworzenie środowiska wirtualnego…

-

Robot Codey Rocky – zabawa i nauka w świecie sztucznej inteligencji

Robot Codey Rocky zachęca do zabawy i nauki. Dzięki prostemu interfejsowi do programowania i wielu czujnikom jest ciekawą propozycją dla dzieci, które mogą postawić swoje pierwsze kroki w świecie sztucznej inteligencji. Codey Rocky swoim wyglądem przypomina kotka lub pieska, czym wzbudza sympatię nie tylko dziecka. Z LED-owego wyświetlacza mruga do nas swoimi oczami, a całości uroku dodają małe uszy. Porusza się na gąsienicach, co sprawia, że kojarzy mi się z sympatycznym WALL-E. Sympatyczny robot chińskiego producenta Makeblock jest przeznaczony dla dzieci w wieku 6+. Jego zadaniem jest pomoc w rozwoju kreatywności poprzez wprowadzenie dzieci w świat robotyki i programowania, a nawet sztucznej inteligencji. Konstruktorzy starali się zaprojektować jak najłatwiejszy i najprzyjemniejszy…